原始链接在: https://www.appinn.com/jan-ai/

Jan 是一款支持 Windows、macOS、Linux 的本地 AI 软件,利用开源 AI 模型和自己的硬件(CPU、显卡),让你在自己电脑上运行大语言模型,实现 100% 完全离线、免费的 ChatGPT。@Appinn

很多同学一直在找可以运行在自己电脑上的大语言模型,这不它来了。

Jan – 免费的 ChatGPT 开源替代

原理就是使用自己的硬件来提供算力,支持:

- Nvidia GPUs (fast)

- Apple M-series (fast)

- Apple Intel

- Linux Debian

- Windows x64

也支持多 GPU 集群,反正你有什么设备尽管上,越多算力越大,速度越快。

兼容 OpenAI API

Jan 提供了 OpenAI 等效 API,可以在本地 1337 端口直接调用。

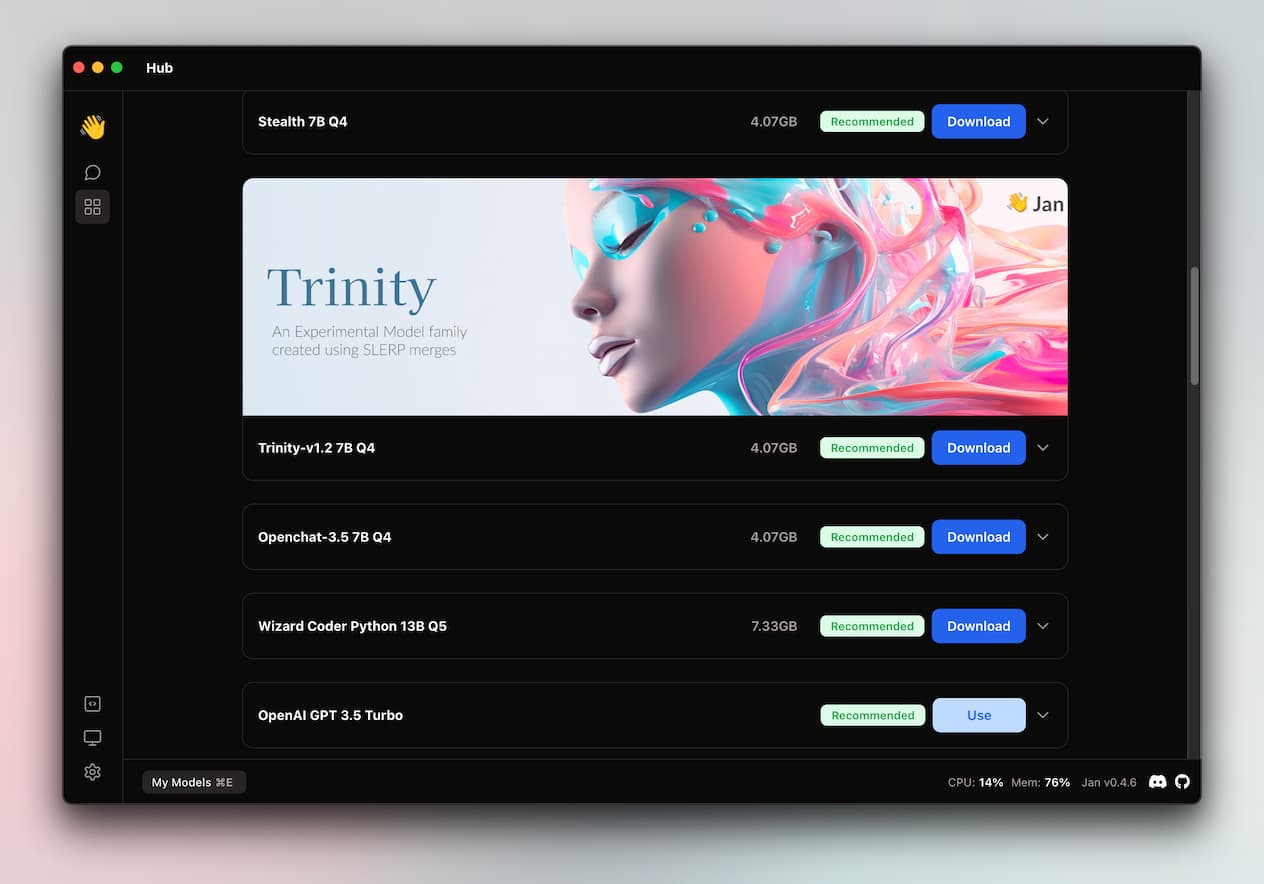

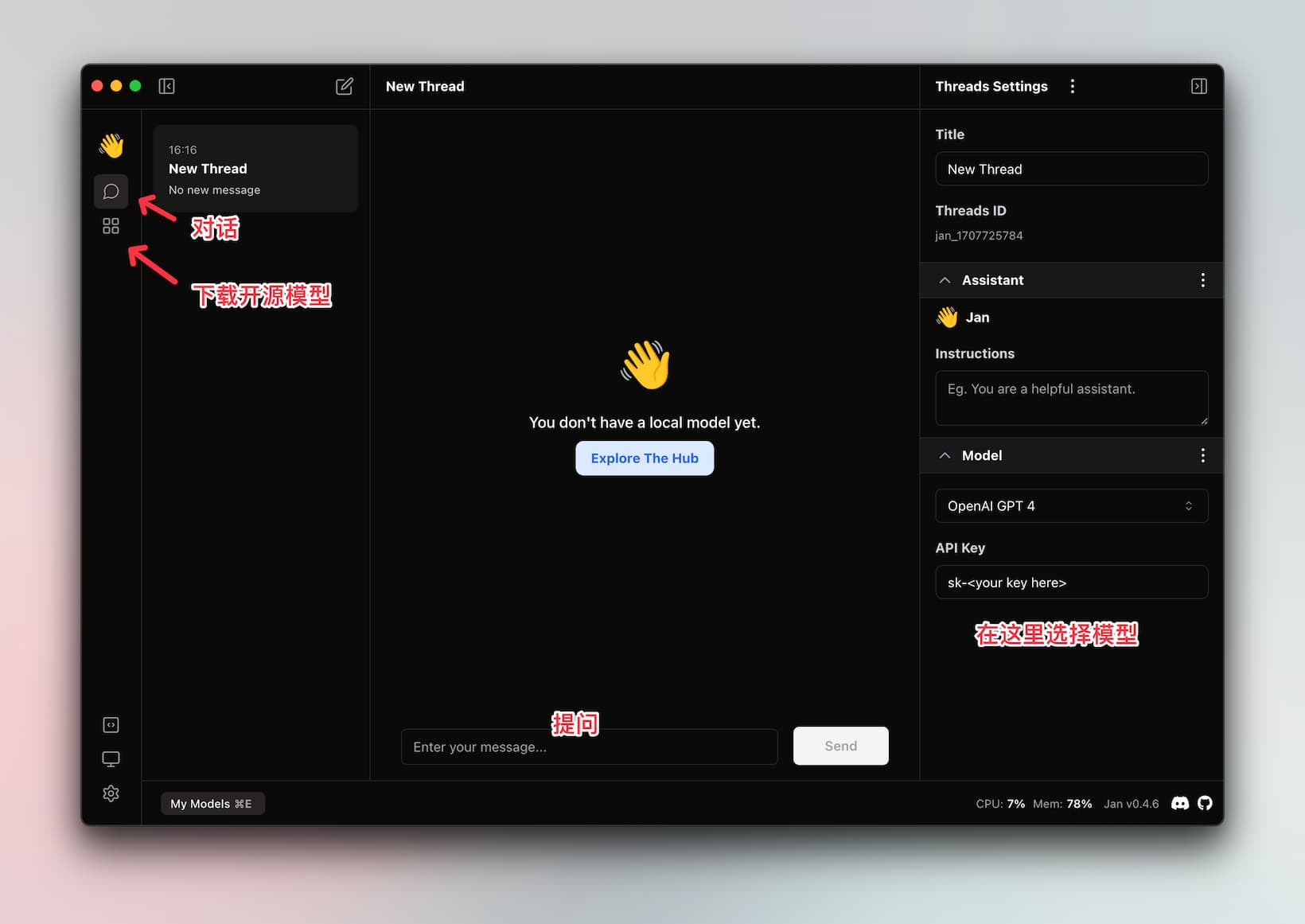

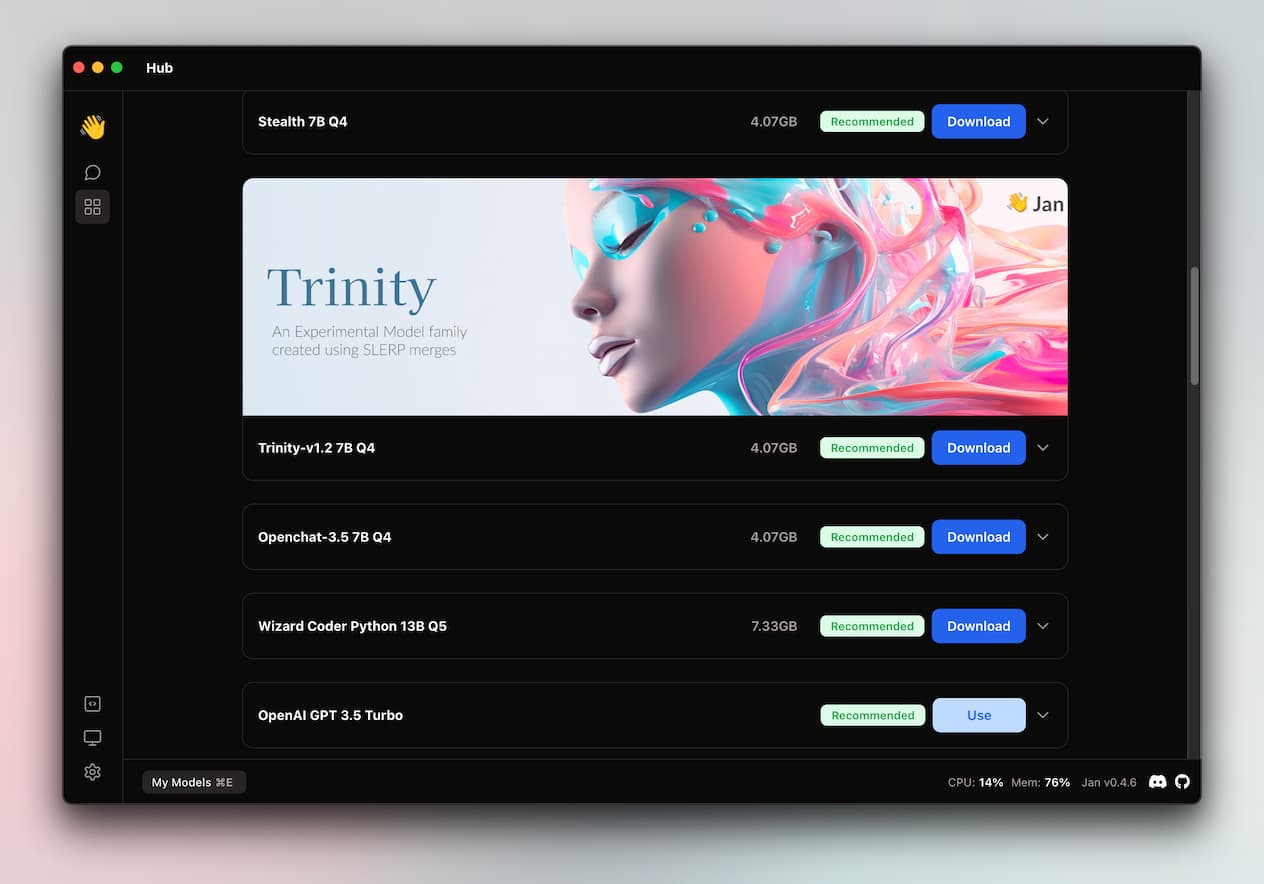

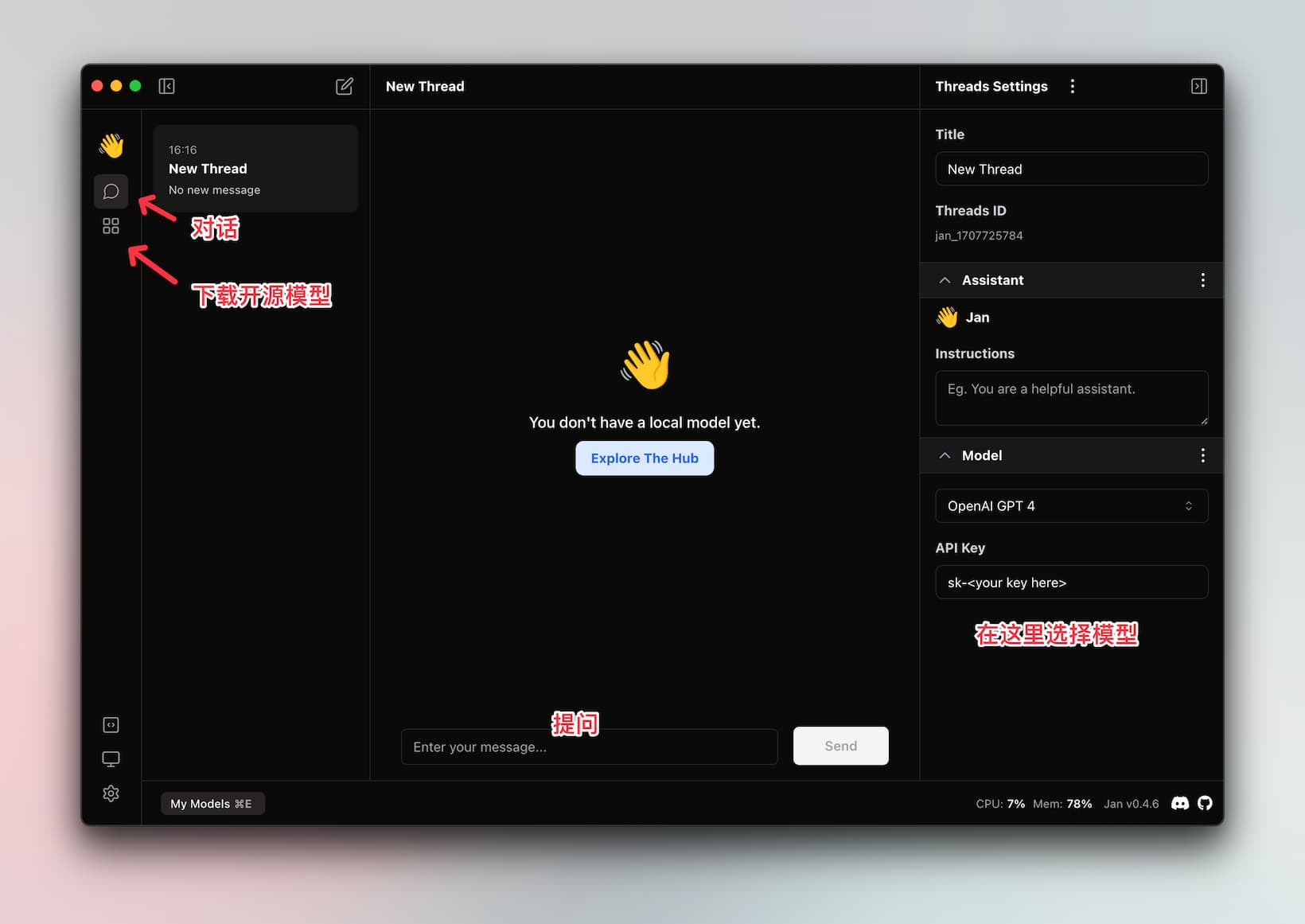

截图

Jan 的使用界面很简单,从边栏选择并下载模型后,就可以直接用了:

用起来,就像和 ChatGPT 一样聊天,只不过这次,算力由你自己的电脑提供。

除了从 Jan 提供的 Hub 选择模型,也支持手动导入模型、使用在线模型(远程服务器)。

青小蛙实在是没有硬件可以测试这个,测试了 OpenAI 的的确没啥问题,推荐给各位 4090 用户玩玩。

获取

原文:https://www.appinn.com/jan-ai/

w568w

3

这种软件实在太多了,我都不知道先推荐哪个同类……真是卷完开源卷速度,卷完速度卷颜值,卷了又卷。关键是还能吸来一堆 Star,颇有一种批量生产流量网红工艺品的感觉……

不用点进去都知道是基于

只是做了个前端界面而已。

我也来推荐一个吧:

优点在于做得比 Jan 早,Star 数比 Jan 多 5 倍。他们自己也训练修剪了一些模型,效果还可以(而且客户端不是用 Electron 而是 Qt 写的)。当然也是基于 llama.cpp 的,性能和兼容性上没区别。

利益相关:有个锤子关系。

p.s. 就现阶段,这种本地模型基本没法当生产力工具,最多专精领域(翻译/分类/识别)……真想称为 ChatGPT 的平替,恐怕还要再等个人电脑算力发展个几年吧。

5 个赞

离线好,不受制于人。

但 需要自己维护预训练的数据?占多大空间–x轴?

需要自己有高性能算力,什么档次的显卡、内存(–y轴)换得多久的等待或什么样的效果?

有没有 这样的大致坐标曲线 方便不同的人衡量选择?

Download for PC

Warning:Jan is in the process of being built. Expect bugs!

Warning:Jan is in the process of being built. Expect bugs!

bieka

6

这个好!试用了下效果不错,另外求问有没有合适的 Stable Diffusion 前端,除了B站上秋叶的那个以外

w568w

7

Stable Diffusion 我用得不多,只能给你推荐原版

这个真挺好用的了,插件资源也多。

Android 上可以用

lama 好,为什么不直接用 lama(我还没用过)

昨天我玩了Jan,没什么用处。

以下是两个问题表现:

- 腹泻了,可以吃一些什么水果?

- 树上有十只鸟,开枪打死一只,还剩几只

模型一:mistral-7b-instruct-v0.1.Q4_K_S的回答:

- 苹果

- 9只鸟

模型二: stealth-v1.3.Q4_K_M的回答:

- 有些水果可能会引起腹泻,例如香蕉、橙子等。

- 9只鸟

L11

10

听说nvidia30系可以用上chatwithrtx了,不知道跟这个比咋样

M芯片版,按装了,但是下载模型的进度是0%,下载失败,全局魔法或者不开魔法也没下载速度,请问如何下载模型啊?