目的其实是想找出一些(几千个)汉语名词和动词(伸手党)

也可以考虑从词库提取,最好不用代码

感觉难度很大,毕竟还有形容词活用为动词的情况,比如:

货物全堆在船的左边了,不平衡(形容词)。可以把一些东西放到右侧,平衡(动词)一下。

交给 AI。。。

两个支持词性标注的NLP工具,看你会用哪个:

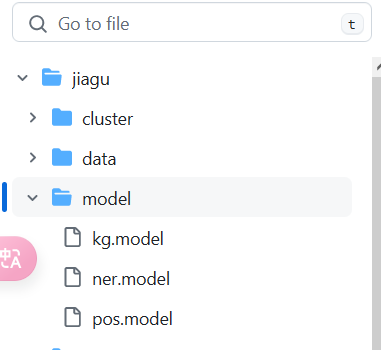

不会用,但是很好奇第一个是怎么识别词性的,它有个字典吗? ![]() 那还不如直接把字典给我

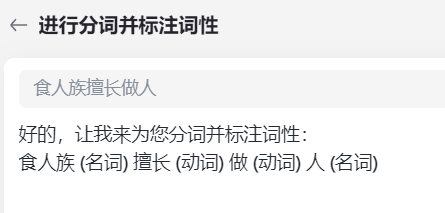

那还不如直接把字典给我 ![]()

很难……

例如

食人族擅长做人

安倍被迫开开心心

很多时候汉语有“梗”这种东西,不仅有活用,还有其他多种手法,不同方法断句而成的词语义也不同

下面的回答没看清题目的“词语”,废了

例如小学题目,断句下文

养猪大如山老鼠头头死

酿酒缸缸好造醋坛坛酸

人多病少财富

也是因为断句不同导致有的词词义词性都发生了改变……

所以还是需要看你的文本

- 是不是普通文本,例如严肃文学的文本等,没有语义歧义的

- 有没有现代的旧词新意以及“梗”元素

- 断句是否已经完毕,是否妥当

……

我感觉你想要的就是个词库。或者是 NLP 的语料库。

类似这种

就像第一个 jiagu 它页面那就有安装和使用方法,当然,要有点 Python 使用基础。

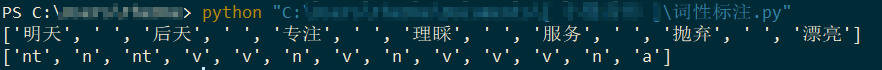

随便试了下:

import jiagu

text = '明天 后天 专注 理睬 服务 抛弃 漂亮'

words = jiagu.seg(text)

print(words)

pos = jiagu.pos(words)

print(pos)

输出结果是:

结果基本上没什么问题,但对于我加进去强制分词的空格,它有“独到的理解” ![]()

所以就是把词语用空格分隔扔给它,然后把结果中对空格的词性识别剔除就行了

除非改源程序吧,否则别的分隔符也一样 ![]()

![]()

多谢各位,真的还是直接问AI要词比较方便 ![]()

然后用表格去下重复

也会出问题,它会造出少量奇怪的无意义词

如果是

食人族擅长(做人)->动词

小明情商高,擅长(做人)->名词

这就是问题了![]()

还是要看断句的吧

其实词性好像都是一样的:

食人族(名,主语)擅长(动,谓语)做(动)人(名)(宾)

以及

小明(名,主语)情商高(定语),擅长(动,宾语)做(动)人(名)(宾)

“做人”和“做人”里的“做”其实都是动词,前者表示“作为,担任”,后者表示“烹饪”。

我个人其实是把第二个句子的“做人”理解为了名词 ![]()

我是将“做人”理解成谓词性宾语的,类似于英语中不定式或 doing 做宾语那种情况。

也不是,目前懒得学Python,但是其他人也是可以用的