这不就是Windows的么,至于你觉得NTFS不好,我觉得可能不是它的锅。站在普通用户用软件恢复的角度,它的衡量点是数据有没有被覆盖,是否会覆盖应该是硬盘的写入机制吧?至于同一块磁盘和系统,有的软件能扫到,有的扫不到,应该是软件的问题了。

我有一次硬盘分区表丢失,数据都在,倒是通过dg免费版恢复的,跟你所说的情形有点相似。

我觉得有这方面因素在里面,另外你用的是免费版吧?如果这样评价软件能力,可能买其最强的版本评价更客观,至于破解还多了一层第三方的因素。

ReFS是NTFS的下一代文件系统,所以我觉得官方不太可能对后者有大的改进,最多是小修小补。

如第一段所述,我觉得这个是硬盘实现的,文件系统到不了这个层面。

我觉得对于已存在覆盖情况的文件,普通用户用软件恢复能用的可能性不大。

M.2是接口吧?盘片要么是机械,要么是固态。

如第一段所说,覆盖恢复,靠纯软件可能解决不了,要用专门的恢复数据设备。

1 个赞

回收站机制是我用错词了,其实是指garbage collection,这里指文件系统的空间回收,是一整套资源管理的设计理念,比如怎么给新文件分配空间才能保证平衡的性能/空间利用/可修复性。

我这次遇到的问题是本来dg已经能提取所所有的好数据,完全可以以此修复受损的那部分$mft,但是它没有这个功能,就是现在已经掌握了所有的数据和大部分完好的索引,现在要根据这个数据和部分索引修复或者重构一个完整的索引,dg不行,所以我推论出可能的两个原因:1.作者能力不太行 2.作者不想做

对软件收费其实是很难公平实现,或者作者吃亏,或者用户吃亏或者体验不好,但是现实情况作者大都是弱势群体。就dg来看作者赚到的与他产生的价值相比肯定过少。

这种小众geek软件本来就有悖论,如果作者做的太好,很多人会拿这个去做数据恢复赚钱,甚至直接拿破解版接活,而作者要是自己做同样的生意也做不大,培养学徒的话也很快就能独立营业,然后肯定就跑掉了,所以影响作者开发的热情。最好的归宿可能还是卖给大公司。但是dg的功能如果想做在算法上其实没太大的难度,毕竟文件系统规格都是公开的资料。

不算ntfs的锅吧,因为如果不是第三方软件问题或者物理损伤ntfs也不会出问题,但是它确实没有提供足够的恢复手段。

refs第一次听说,搜了下貌似还有bug和兼容问题,而且refs完全不支持数据恢复,普通人不被推荐使用,目前看来就是微软没把refs做到能家用,之前的ntfs也不再升级了。

其实不应该说是ntfs操作磁盘,应该是磁盘驱动在读写磁盘,我只能猜测windows 磁盘驱动应该还是对硬盘的物理结构进行直接操作的,因为像分区表什么都是在0磁道0柱面之类的位置,因为这里读写速度最快。

碎片整理功能大概也需要直接用物理位置。

前几十年机械硬盘是主流,而且软盘硬盘内外圈的读写性能差太多,ntfs在设计上不能不考虑内外圈速度差,不可能让用户发现硬盘越满速度越快。。。现在的ssd应该就是逻辑模拟的 柱面-磁头-扇区了。

1 个赞

Light2k

(2k)

24

dg版本很多的,免费版付费版还有国际版。你要说他修固态那确实不咋滴。修分区表应该还是没问题的,$mft我记得是ntfs本身是前中后有完整3份,要有至少一份未损毁太能比较顺利的恢复,要不然就只能靠扇区慢慢扫了。

1 个赞

Light2k

(2k)

25

关键词,

完整+误删+关机拔硬盘 =recuva

完整+误删+未及时关机 +企业数据=手工恢复

完整+误删+未及时关机 +个人数据=今天疯狂星期四,在那emo不如吃点好的

能全盘备份就全盘备份,硬盘不够就只做文本文件备份。其他扫个文件名索引。

2 个赞

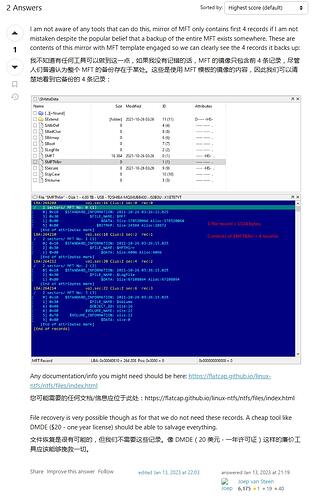

$mft只有一个备份$mftmirr,而且$mftmirr非常不完整,官方说法记得是at least 4 records,也就是可能只有4个文件的记录

Each MFT entry is 1024 bytes in size

$mft里面每条记录是1k,1000个文件大概就是0.1M,现在来看非常的小,可能当初在1.44M软盘上已经算是相当的大了,所以才设计成这个样子。

其实在硬盘普及的时代就应该增加备份数量了,ntfs拖到现在仍然没有做

Light2k

(2k)

27

倒逼用云盘啦,阳谋,搞那么多冗余微软又赚不到一个子儿