原始链接在: 泼凉水:我不配部署 DeepSeek R1 - 小众软件

DeekSeep 爆火,开源,超越 OpenAI o1,便宜(限量免费)、量足,目前已经有无数的教程教你在电脑上部署、在NAS 上部署,甚至在手机上部署。

不过,我不配去部署 DeepSeek R1…

我不配

但是,我没折腾,完全没折腾,因为…我不配。

我没有高等级 CPU,没有大内存,没有顶级显卡,唯一满足的,就是NAS里的硬盘了(实际上有个2TB就够了)。

还有,你自己部署的,一定一定一定没有 DeepSeek App 好用!

这…

这就很尴尬,折腾一圈不如安装个 app 用的爽。而在我询问了好几个群以后,折腾过的同学都表示:不如直接用 App…

更何况现在这个 App 还免费,还排在全球100多个国家的应用商店榜首。

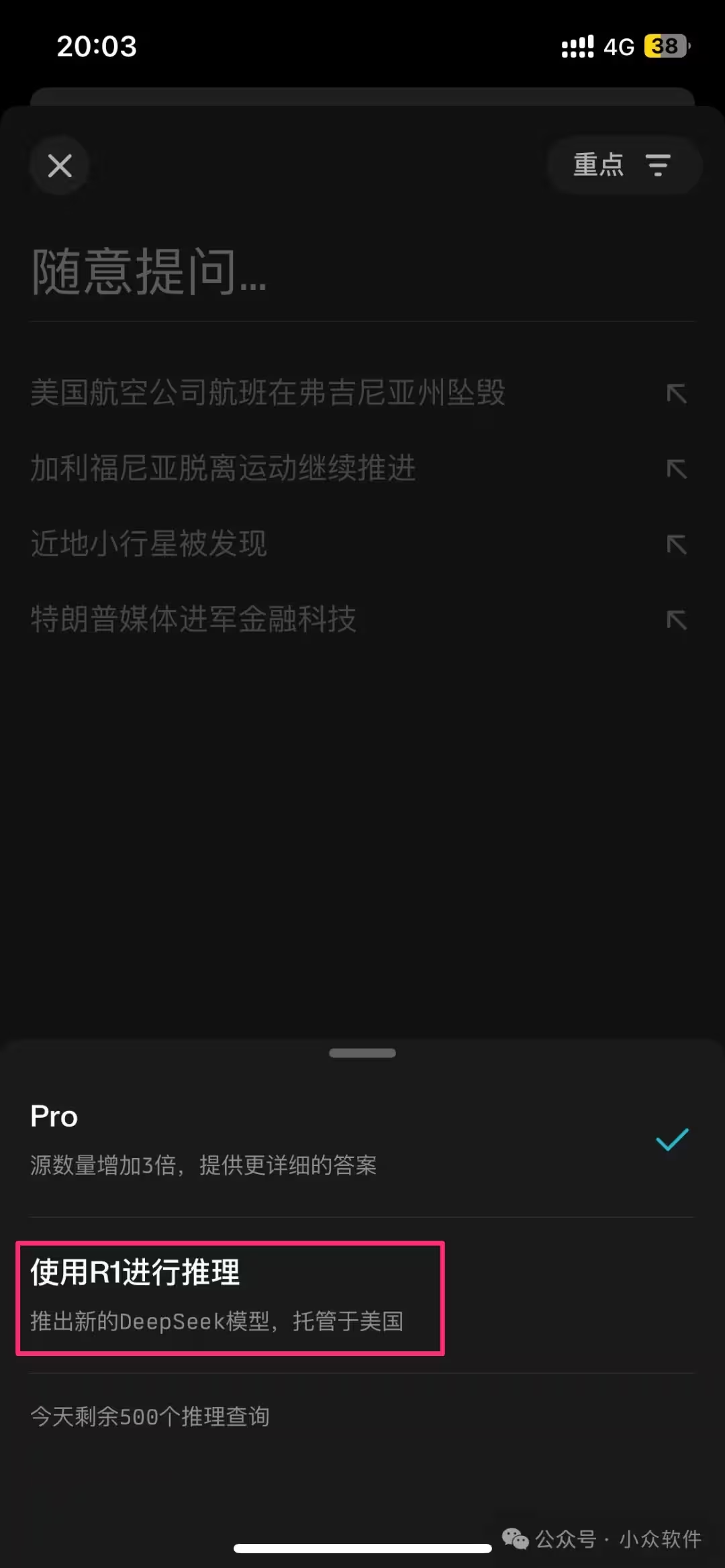

甚至,有专业的国外AI公司都提供了服务:

所以,非必要,不折腾。去应用商店下一个试试吧。

但是

但是,和之前一样,你不要问他:你使用了什么模型?为什么周树人暴打鲁迅 这种无意义的问题…

因为真的很无意义啊。

你可以这样问(以下内容出自 R1 推理):DeepSeek 的最佳提问方式是什么?

以下是得到的回复:

向 DeepSeek 提问的三个最佳实践:

1. 明确问题领域

- 说明具体主题领域(如生物、编程、哲学等)

- 提供关键专业术语

- 示例:”量子计算在当前制药行业的实际应用案例有哪些?”

2. 设定回答框架

- 注明需要的格式要求(如列表/流程图/代码等)

- 指定思维路径(如第一性原理分析)

- 示例:”请用SWOT分析法解读新能源车行业现状”

3. 添加限定条件

- 设定上下文背景(时间/地域/行业等)

- 明确答案深度(学术级/通俗化)

- 示例:”用初中生能理解的方式解释区块链技术”

优质提问示例:

“作为传染病学研究员,需要2020年后发表的关于冠状病毒跨物种传播机制的英文核心期刊文献,请用MLA格式推荐5篇并附150字摘要。”

这种提问方式能帮助 DeepSeek 准确理解需求,提供结构清晰、专业可靠的回答。建议用户在提问时尽量明确具体的应用场景和知识背景。

甚至,你可以把问题交给R1,问它该如何提问:我想知道抖音的打赏用户心理,该如何向 R1 模型提问?

以下是一个面向大型语言模型(R1级别)的优化提问方案,结合了AI特性与用户研究需求:

结构化提问模板:

“请以社会认同理论和情绪唤醒模型为框架,构建抖音打赏用户的五维度心理分析模型,要求:

维度包含:

- 虚拟身份建构 (使用Goffman拟剧论)

- 即时反馈依赖 (多巴胺奖赏机制)

- 阶层跨越幻想 (参照Veblen炫耀性消费)

- 孤独经济效应 (结合Weiss孤独量表)

- 群体规范压力 (运用Asch从众实验原理)

输出形式:

- 绘制各维度关联的环形示意图

- 制作用户决策流程图(包含4个关键决策节点)

- 按打赏金额梯度(50/500/5000元)分层解析心理差异

数据要求:

- 引用近三年SSCI期刊相关文献

- 整合平台算法推荐机制的影响因子

- 对比直播间场景与短视频场景的行为差异”

技术适配说明:

- 理论嵌套:明确指定经典理论确保分析深度

- 可视化指令:要求图示满足认知心理学记忆规律

- 参数化条件:金额分层符合行为经济学研究范式

- 场景对比:增强模型的情景识别精度

预期知识产出:

- 虚拟互动中的身份位移模型

- 即时反馈循环的神经机制图谱

- 打赏金额阈值的心理账户分类

- 跨场景行为迁移的阻促因素

该提问方式通过结构化参数设置,能有效激活语言模型的多模态处理能力,产生兼具学术严谨性和实践洞察力的深度分析报告。建议配合追问指令如”请展开第三个维度的神经经济学解释”进行知识深挖。

专业的提问交给 R1,完美。

快去下个 App 吧。

不会提问没关系,问 AI 如何提问也是一个好问题。

关注我们

- 微博:https://weibo.com/appinncom

- B站:https://space.bilibili.com/10979326

- 微信公众号:搜索「小众软件」

- 小红书:https://www.xiaohongshu.com/user/profile/61459ee9000000000201fae3

- 爱发电:https://afdian.com/a/qingxwa (打赏我们,让我们更好的创作)

- TG频道:@appinnfeed

- Facebook:https://www.facebook.com/appinncom/

- X:https://x.com/appinn